jueves, 26 de marzo de 2009

plataforma dragon

amd vs intel

Comparan un AMD AM2 FX-62 con un Core 2 Extreme X6800 en 7 juegos como son World of Warcraft, Need For Speed: Carbon, F.E.A.R. Extraction Point, Battlefield 2142, Medieval II: Total War, Flight Simulator X y Elder Scrolls IV: Oblivion. El sistema gráfico utilizado es un SLI de GeForce 8800 GTX.

Naturalmente y esto no sorprende a nadie comentan que en general consiguen mejor rendimiento con el procesador Intel y que donde han apreciado más diferencias es en Flight Simulator X y Medieval II: Total War donde pueden poner niveles de calidad gráfica un poco más altos con el procesador de Intel y seguir jugando igual de fluido.

A pesar de esta monstruosa configuración se han encontrado con parones en Oblivion y NFS: Carbon, claro que lo hacen con detalles altos, filtros y resoluciones de 2560x1600, en otros juegos han probado la resolución de 2048x1536. Creen que es posible que incluso los 768MB de la GeForce 8800 GTX podría ser insuficiente para estos niveles de detalle y sobretodo en SLI.

Con todo, creen que al querer utilizar tarjetas gráficas de gama muy alta o SLI cada vez se nota más la diferencia entre los procesadores actuales de AMD e Intel, recomendando acompañar estas VGAs con el mejor procesador que podamos montar, sin embargo y bajando a un nivel terrenal donde el usuario tiene presupuesto por una VGA de 200€ o a mucho estirar 250€ y con resoluciones más habituales, las diferencias entre procesadores serán mucho más modestas/negligibles y por lo tanto aún para jugar es mucho más importante mirar e invertir en una VGA potente que en el procesador.

nvidea vs ati

Una de las mejores compras que se pueden hacer a gusto personal a día 9 de febrero seria comprar dos ATI HD3870 o una HD3870×2 (apara los que tengan espacio en su placa base porque esta tarjeta es gigante!! ) por unos 400€ para los gamers más exigentes y si no una 8800 GTS o dos HD3850. Las dos opciones rondarían los 300 y poco euros y sacarían un gran rendimiento a los juegos menos a Crysis y algunos de sus características, aunque podrían jugar igualmente. Aquí tengo que decir que la mejor opción serían las HD3850, les sacaras más rendimiento que a la 8800 GTS, si tuviera que ampliar la gráfica de mi ordenador son las que escogería.

Parece que de momento ATI/AMD está ganando la partida gracias a sus módicos precios más razonables que los que ofrece Nvidia y su velocidad en avanzar de tecnología antes que sus competidores, además de que adelantó la fecha de salida de sus últimas creaciones para tener más tiempo antes de que salgan las nuevas series de Nvidia.

Ahora la pelota está en el tejado de Nvidia: ¿Sus nuevas series que se espera que salgan este mes serán un método de contrarrestar la diferencia que ha dejado ATI sobre sus gráficas o serán de una potencia mejor y con precios razonables? Juzguen ustedes mismos.

amd phenom II

Lógicamente, éste record se ha llevado a cabo gracias a una refrigeración en nitrógeno líquido con la que se ha obtenido una temperatura del micro de -230 grados centígrados. Al igual que aquella primera noticia, lo más sorprendente es que se ha duplicado la frecuencia final de la CPU, partiendo de los 3.0 GHz del Phenom II 940 hasta estos 6.5 GHz.

Curiosamente, tenemos que tener en cuenta que los Phenom II apenas llevan unas semanas en el mercado, desde su lanzamiento el pasado 8 de enero. Ya se encuentran en muchas tiendas, españolas incluidas, pero lo mejor está por llegar: lo mejor no sólo de los Phenom II de fábrica, sino también lo relativo a las posibilidades de overclocking que los nuevos micros de AMD tendrán en un futuro.

Si ya se ha conseguido duplicar la frecuencia de una CPU Phenom, es posible que con el paso del tiempo y el consecuente lanzamiento de nuevos modelos de micros y placas lleguemos incluso a triplicar o cuadruplicar las frecuencias base de los microprocesadores, siempre basándose en el nitrógeno líquido al ser éste el sistema más eficiente para este tipo de records.

Otra cosa es en el ámbito doméstico. En nuestras casas, lo más seguro es que un AMD Phenom II pueda overclockearse de una forma más sencilla y eficiente que un microprocesador Intel, pero no a los niveles que se consiguen con el nitrógeno líquido. Yo diría que con que un usuario doméstico consiga una mejora del 20 o 30% en la frecuencia base, ya es más que suficiente para que sea un completo éxito. Y eso, a día de hoy, no parece nada complicado con los Phenom II.

verificar estabilidad

ventilacion

Los ventiladoresTodas las cajas del tipo ATX, semitorre o torre, disponen de una fuente de alimentación con su ventilador extractor. Además, este tipo de cajas suelen incorporar los taladros y ranuras para añadir un extractor adicional, en la parte superior trasera, y un ventilador inyector, en la parte inferior delantera. Lo que vamos a hacer es, justamente, montar estos dos ventiladores. De este modo conseguimos renovar el aire. Además, si tenemos ganas de hacer algo (poco) de bricolaje podemos añadir un ventilador inyector en el lateral para llevar aire frío hacia las tarjetas PCI. Hay que tener en cuenta que las aceleradoras 3D se calientan mucho. A tal efecto, practicaremos en la tapa lateral de la caja, y más o menos a la altura de la tarjeta 3D, 4 taladros a la medida de los tornillos de sujeción del ventilador y le practicaremos un agujero, más o menos del diámetro del mismo ventilador. Si queremos optimizar el flujo de aire hacia las tarjetas, podemos añadir al ventilador un tubo coarrugado del mismo diámetro que dirija el aire desde la tapa hacia las tarjetas (en las cajas medianas la longitud del tubo será de más o menos 50mm).

El flujo resultanteCon todo esto, conseguimos que el aire del interior de la caja se renueve constantemente en un flujo más o menos como el del gráfico. El aire frío entra por la parte inferior, se calienta al entrar en contacto con los diferentes dispositivos y sale por la parte superior. Sólo con esto cualquier configuración normal tendría que funcionar dentro de los parámetros de temperatura aconsejados por los fabricantes. El presupuesto para esta modificación es de 3.000 pesetas, contando que cada ventilador adicional cuesta más o menos 1000 pesetas por unidad y que la instalación nos la hacemos nosotros.

voltaje y disipacion

Overclocking: Guia para novatos

Índice del artículo 1. Introducción2. Las formas de overclocking3. La importancia de los buses secundarios4. Placa, memoria, disipación y suerte5. Voltajes, disipación...buscar el equilibrio.6. El overclocking es asequible7. El proceso de verificar la estabilidad y el aumento de rendimiento.8. Algunos resultados

FOROS HZ

¡¡PARTICIPA EN NUESTRA COMUNIDAD!!

Foro de Overclocking, Hardware, juegos y mucho más.click aquí

En esta guía podeis conocer en que consiste el overclocking, como llevarlo a cabo, cuales son sus principales conceptos y también un poco de historia sobre esta tendencia del PC que se remonta ya a los tiempos del 486.

window.google_render_ad();

Voltajes, disipación...buscar el equilibrio.Aumentar las frecuencias de cualquier componente lleva al consumo de mayor energía y por tanto a la generación de mas calor. Cuando consumimos mas energía podemos requerir mas corriente para mantener alimentado el procesador en estas nuevas condiciones. Cuanta corriente pasemos por los transistores del procesador mas calor generarán estos y por tanto mas capacidad de disipación necesitaremos. Dentro de esta combinación de factores: velocidad, corriente y energía a disipar, debemos encontrar el equilibrio para que nuestro procesador corra todo lo posible dentro de nuestras posibilidades de disipación y dentro de nuestras necesidades. Algo debe quedaros claro y es que cuando aumentamos la frecuencia de trabajo del procesador, cuando subimos su voltaje y cuando aumentamos el calor que este produce estamos acortando su vida útil y si hacemos las cosas sin el debido cuidado, si nos saltamos las propias barreras que el procesador nos va marcando y no tenemos paciencia con un proceso que solo se rige mediante prueba y error, entonces podemos dañar nuestro procesador de forma irremediable. En toda mi experiencia haciendo overclocking a todo tipo de procesador jamás he visto un solo micro estropeado por el propio proceso pero si por cosas ajenas al mismo como disipadores mal montados, fugas de agua en sistema de refrigeración, mal aislamiento del procesador o placa en sistema de refrigeración bajo cero....en estos casos no fue el overclocking quien daño el procesador u otros componentes, fue sin duda la mala manipulación de los mismos.

La variable preponderante en esta ecuación de equilibrio entre voltaje, disipación y velocidad es sin duda la disipación. Los componentes electrónicos agradecen las temperaturas mas reducidas posibles, funcionan mejor así, pero en los procesadores actuales la generación de calor es muy alta. Aunque parece que se vuelve al camino de la eficiencia por vatio de calor generado lo que es a día de hoy la temperatura es un factor fundamental. Por eso, como habéis podido ver en estas mismas paginas, cuando usamos un sistema que es capaz de dejar el procesador a temperaturas bajo cero las frecuencias que se alcanzan suelen ser en torno al 70% de overclocking cuando con un disipador convencional el limite suele rondar el 30%. Sabiendo esto es cuando debemos valorar si nos compensa gastarnos un dineral en un buen sistema de refrigeración o simplemente usar lo que tenemos para ganar todo lo posible a nuestra maquina sin tener que gastarnos ni un solo duro más.

board, memoria disipacion y suerte =)

En cuanto a los procesadores todos los micros son susceptibles de hacer overclocking en ellos. Si buscamos algo especial deberemos mirar sobretodo las prestaciones que buscamos del procesador y también su combinación de bus y multiplicador que mas se ajusta a nuestras necesidades. Un procesador con mucho bus pero poco multiplicador nos limitará mucho el aumento de frecuencias ya que necesitaremos un gran aumento del bus frontal para poder alcanzar cotas interesantes. Por otro lado un procesador con mucho multiplicador y poco bus, como por ejemplo el Pentium D 805 que tiene un bus de 133MHz reales y un multiplicador de 20x, hace que con la mas mínima subida las frecuencias reales se disparen. Lo mejor es buscar un equilibrio. Actualmente lo ideal, según el bus de 200MHz que se maneja actualmente en casi todos los procesadores y mirando también mucho de cara al Core 2 Duo y al AM2, lo ideal seria un multiplicador de 12x y un bus frontal de fabrica de 200MHz. Con esta combinación podemos llegar a overclockings extremos muy sorprendentes.

formas de overclocking

ventilacion para la fuente de poder XD

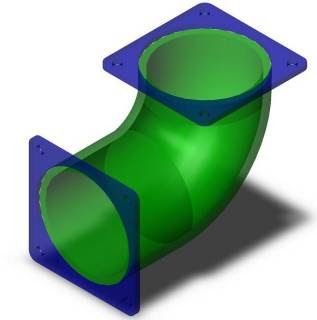

2. Un codo de tubería ( Este también varia dependiendo del diámetro de tus ventiladores…como no se consiguen medidas iguales a la de nuestros ventiladores trata de conseguir uno de una medida parecida….en mi caso el diámetro del codo es de 83mm)

Ahora habláremos de la tobera (codo de tubería en PVC) el corte de esta debe ser muy preciso ya que un mal corte es primordial a la hora de ensamblar la tobera a la parte posterior del chasis, en este caso es recomendable tener una escuadra para saber que el corte es preciso. Ahora veremos la imagen de la tobera.

En la vista lateral de la tobera vemos que ambas salidas son totalmente horizontales, como ya dije anteriormente esto es esencial para el ensamble de los componentes.Ahora proseguimos a la unión de la tobera y la base…para esto necesitaremos algo de pega y masilla epoxica para la unión de ambas piezas, también podemos utilizar algo de silicona.Debemos tener cuidado a la hora de ensamblar nuestras piezas, tratemos de que los orificios de la tobera y de la base coincidan para evitar que el flujo de aire se vea afectado.Aquí esta el ensamble final entre tobera y base.

Si nuestra fuente de poder solo tiene un ventilador debemos modificar la carcasa de esta para montar el otro ventilador, esto lo hacemos con el dremel.Abrimos un orificio del diámetro del ventilador que vamos a utilizar en la parte trasera de la fuente con sus respectivos orificios de agarre.El ensamble final de la tobera con los ventiladores queda asi.

Luego de tener todo esto listo seguimos con el montaje de la tobera a la fuente, antes de esto los que no tienen una fuente con un ventilador en su parte trasera debemos hacerlo.El montaje de las piezas es muy sencillo, debemos tener presente que debe quedar bien apretada la tobera a la fuente para así evitar perdida de aire por los lados de la base. Para esto podemos utilizar un poco de silicona para sellar lo espacios que quedaron entre la tobera y la fuente.El montaje final queda asi.

ahora Viena la parte complicada del MOD.El orificio del gabinete debe estar bien centrado…tómense el tiempo necesario para tomar las medidas correctas. Este orificio debe coincidir exactamente el orificio de la tobera.Ahora solo queda atornillar y disfrutar de un buen sistema de ventilación para nuestra fuente…no olviden conseguir una rejilla para el ventilador que va pegado con el gabinete. SUERTE.

overclocking

Esta práctica se popularizó en los últimos tiempos, ya que no merecía la pena perder el componente por ganar unos pocos megaherzios. El overclocking ya está más avanzado y permite forzar los componentes aún más (muchas veces cerca del doble) sin que pase nada, siempre que tengan una buena refrigeración.

Este aumento de velocidad produce un mayor gasto energético, y por tanto, una mayor producción de calor residual en el componente electrónico. El calor puede producir fallos en el funcionamiento del componente, y se debe combatir con diversos sistemas de refrigeración (por aire con ventiladores, por agua o con una célula Peltier unida a un ventilador).[2] A veces, los fallos producidos por esta práctica, pueden dañar de forma definitiva el componente, otras veces, pueden producir un reinicio que conlleva la pérdida de datos de las aplicaciones abiertas, o en algún caso, la pérdida del sistema de archivos entero.[3]

Esta práctica está muy extendida entre los usuarios de informática más exigentes, que tratan de llevar al máximo el rendimiento de sus máquinas. Los consumidores menos atrevidos suelen comprar componentes informáticos de bajo coste, forzándolos posteriormente y alcanzando así el rendimiento esperado por los componentes de gama más alta. Por otro lado, los consumidores más fanáticos pueden llegar a adquirir componentes de última hornada para forzar su funcionamiento, y conseguir así pruebas de rendimiento inalcanzables para cualquier equipo de consumo. Por este motivo, la mayoría de los fabricantes decide no incluir en la garantía de su hardware los daños producidos por overclockearlos.

Hoy en día fabricantes de hardware producen sus productos desbloqueados para permitirles a los usuarios realizar overclock sobre los mismos.[4] Es el caso de, por ejemplo, placas de video, microprocesadores, etc.

modding

El modding es el arte o técnica de modificar estética o funcionalmente partes de un ordenador, ya sea la torre, mouse, teclado o monitor. A todo el que practica o hace el modding se le llama "modder". Sin embargo, la palabra modding se suele usar frecuentemente para las modificaciones realizadas a un ordenador o a algo relacionado con él, como son los periféricos, accesorios e incluso muebles que lo rodean.

El modding es personalizar los PC añadiéndole, modificando o en muy raras ocasiones, sacándole partes, modificando la estructura de la caja, añadiendo componentes, modificando la forma de estos para obtener mayor espectacularidad y diseño, en definitiva es el arte de darle forma y color al PC poniendo en ello toda la imaginación que se pueda tener.

Las modificaciones más comunes que hoy en día se realizan a los ordenadores son:

Sustitución de diodos LED por otros más potentes o cátodos fríos de diferentes colores.- Sustitución de cables IDE por Cables IDE redondeados y/o reactivos al UV (mejoran la refrigeración del gabinete)

- Pintado interior o exterior (incluidos componentes electrónicos).

- Construcción de ventanas para hacer visible el interior o conseguir un efecto estético (con metacrilato).

- Construcción de blowholes (entradas o salidas de aire con ventiladores de fácil acceso).

- Colocación de ventiladores para mejorar la refrigeración de los componentes electrónicos.

- Colocación de un BayBus externo (controlador de los ventiladores que hay en el interior del gabinete)

- Colocación de elementos de iluminación interior y a veces exterior.

- Construcción de elementos para monitorizar las temperaturas de los componentes electrónicos o controlar la velocidad de los ventiladores (Baybus, Fanbus, Rheobus).

- Sustitución total o parcial de los elementos de refrigeración convencional por elementos de